Materialien

Auf dieser Seite finden Sie Materialien, die für wissenschaftliche Zwecke und dem Einsatz im Bildungsbereich kostenfrei zur Verfügung gestellt werden. Bitte beachten Sie die Zitierhinweise in den einzelnen Rubriken.

Non-parametric Continuous Norming (cNORM)

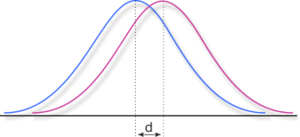

Based on the approach suggested by A. Lenhard et al. (2016), the R package cNORM provides methods for generating non-parametric regression based continuous norms, as f. e. for psychometric test development, biological and physiological growth curves, and screenings in the medical domain. It is available via https://github.com/WLenhard/cNORM. References

Latent Semantic Analysis (LSA)If you are interessted in applying LSA on texts in German language, please have a look at conText. You can use the code on this page in combination with the semantic space in conText to do similarity comparisons on word and text material in German. If you are looking for specialized semantic spaces, please contact me. I am open for scientific cooperation.

| |

Berechnung von EffektstärkenMit dem Effektstärke-Tool könn

Schreibwortschatz von Grundschulkindern: Vergleich 1997 - 2006Natascha Jüngling replizierte im Rahmen ihrer Diplomarbeit die Erhebung von Richter (1998), die mittels der Auswertung von Schüleraufsätzen einen Korpus des produktiven Wortschatzes von Kindern kompilierte. Ziel der neuen Studie war es zu untersuchen, über welchen Schreibwortschatz Kinder der dritten und vierten Klasse aktuell verfügen, und in wieweit sich dieser innerhalb eines Jahrzehnts verändert hat. Hierfür wurden die ursprünglichen Aufsätze von Richter digitalisiert und die gleichen Themen erneut erhoben. Die Datenbank enthält 8315 lemmatisierte Lexikonseinträge von aktiv von Kindern verwendeten Wörtern. Die Einträge sind hinsichtlich ihrer Wortart klassifiziert und sie enthalten Angaben darüber, in welchem Jahr und ob sie von Jungen oder Mädchen das jeweilige Wort verwendet wurde. Weiterhin finden sich alle Varianten des Wortes. Der Korpus ist insbesondere für die Erstellung von Trainings- und Testmaterialien nützlich, da daran überprüft werden kann, wie geläufig die Wörter bei Kindern der zweiten Hälfte der Grundschulzeit sind. Download der Datenbank (Excel-Tabelle)

| |

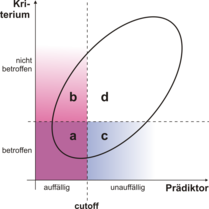

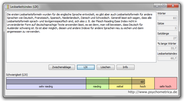

Auswertungshilfe zur Berechnung von Testkennwerten von ScreeningverfahrenScreening-Verfahren haben das Ziel, Personen zu identifizieren, die ein bestimmtes Merkmal aufweisen. Häufige Anwendung finden sie in der Identifizierung von Risikopersonen, die später psychische Störungen, Krankheiten oder schulische Probleme entwickeln. Zur Bewertung der Screenings gibt es eine Reihe an Kennwerten, von denen Sensitivität und Spezifität die bekanntesten sind. Sie geben jeweils wieder wie viele Personen vom Test korrekt als Risiko- und wie viele als Nicht-Risiko-Personen erkannt wurden. Neben diesen grundlegenden Angaben gibt es aber noch eine Reihe weiterer wichtiger Angaben, wie beispielsweise die Prädiktor-Treffer-Quote oder der RATZ-Index (Relativer Anstieg der Trefferquote gegenüber der Zufallstrefferquote; weitere Informationen und eine detailierte Beschreibung der verschiedenen Kennwerte finden Sie in Marx & Lenhard, 2010). Das unten zum Dowload verfügbare Excel-Tabellennlatt soll die Berechnung dieser verschiedenen Werte erleichtern. Tragen Sie hierzu die konkreten Fallzahlen in die farblich markierten Spalten ein.

Literatur: Marx, P. & Lenhard, W. (2010). Diagnostische Merkmale von Screeningverfahren. In M. Hasselhorn & W. Schneider (Hrsg), Frühprognose schulischer Kompetenzen. Göttingen: Hogrefe.

|  |

Lesbarkeitsindex LIXLesbarkeitsindizes haben das Ziel, die Schwierigkeit eines Textes zu bestimmen. Die Komplexität eines Textes lässt sich allerdings nicht direkt erfassen und auch für Experten ist es schwierig, eine exakte Einschätzung vorzunehmen. Eine Möglichkeit besteht darin, Merkmale des Textes zu verwenden, um Rückschlüsse auf die Lesbarkeit zu ziehen. Zu den Merkmalen zählen beispielsweise die Länge der Sätze und Wörter, die Anzahl an Silben in den Wörtern usw. Eine sehr populäre Formel wurde von Björnsson 1968 vorgeschlagen - der Lesbarkeitsindex LIX (im Originaltext 'Läsbarhetsindex'). Dieser ergibt sich aus der Summe der durschnittlichen Satzlänge eines Textes und des prozentualen Anteils langer Wörter (mehr als sechs Buchstaben). Das Programm ermöglicht die Einschätzung der Lesbarkeit von Texten.

|  |

Auswertungshilfe KLASSE 4Klasse 4 (Kombiniertes Leistungsinventar zur allgemeinen Schulleistung und für Schullaufbahnempfehlungen in der vierten Klasse; Lenhard, Hasselhorn & Schneider, 2011) ist ein diagnostisches Verfahren, dessen Ziel die ökonomische Überprüfung der Leistung in einem breiten Spektrum verschiedener schulischer Leistungsanforderungen ist. Das Verfahren ist in der vierten Klasse als Gruppentest zur Erhebung des Leistungsstandes einer Klasse einsetzbar. Zur Erleichterung der Auswertung und der Ermittlung der Schullaufbahnempfehlung steht unter http://www.psychometrica.de/klasse4.html eine Auswertungshilfe bereit, die die Ermittlung der Ergebnisse und der weiterführenden Berechnungen erleichtert.

|  |

Conventional methods for producing test norms are often plagued with "jumps" or "gaps" (i.e., discontinuities) in norm tables and low confidence for assessing extreme scores. cNORM addresses these problems and also has the added advantage of not requiring assumptions about the distribution of the raw data: The norm values are established from raw data by modeling the latter ones as a function of both percentile scores and an explanatory variable (e.g., age) through Taylor polynomials. The method minimizes bias arising from sampling and measurement error, while handling marked deviations from normality – such as are commonplace in clinical samples. Contrary to parametric approaches, it does not rely on distribution assumptions of the initial norm data and is thus a very robust approach in generating norm tables.

Conventional methods for producing test norms are often plagued with "jumps" or "gaps" (i.e., discontinuities) in norm tables and low confidence for assessing extreme scores. cNORM addresses these problems and also has the added advantage of not requiring assumptions about the distribution of the raw data: The norm values are established from raw data by modeling the latter ones as a function of both percentile scores and an explanatory variable (e.g., age) through Taylor polynomials. The method minimizes bias arising from sampling and measurement error, while handling marked deviations from normality – such as are commonplace in clinical samples. Contrary to parametric approaches, it does not rely on distribution assumptions of the initial norm data and is thus a very robust approach in generating norm tables.